蜘蛛抓取频次,这个概念好像被很多SEO优化人员忽视,特别是一些中小型站点。但就在前些时间,May发现我的SEO博客上经常出现一些莫名其妙的蜘蛛,甚至因为360蜘蛛的多次访问,直接导致服务器崩溃。不管您是否有遇到过类似的问题,但是May觉得还是非常有必要了解一下蜘蛛抓取频次,虽说蜘蛛抓取频次并不是影响网站排名的因素,但从某种角度来说,它与搜索引擎优化还是有着千丝万缕的关系。本文全新解读:蜘蛛抓取频次对SEO优化的影响。

蜘蛛从抓取目的,我们可以简单分为三类

①. 搜索引擎蜘蛛,比如:BaiduSpider, GoogleBot,BingBot等;这类蜘蛛在互联网上所有的网页进行爬行及抓取,并建立索引库;根据内部相关算法,当用户搜索相关问题时,将相关的搜索结果呈现在用户面前。

②. 第三方web服务蜘蛛,比如:AhrefsBot, SemrushBot等;这类蜘蛛也会爬行互联网上的众多网页,来收集网站上的信息,将网站上的数据存进他们的数据库,并对其进行分析归类,可以用来分析自己网站或竞争对手网站运营状况。

③. 黑客蜘蛛,通常通过各种蜘蛛来扫描网站上的各种漏洞,一旦抓住漏洞,它们会尝试着访问网站或服务器。

既然蜘蛛有这么多种类,那怎么区分蜘蛛的好坏?最简单的方法就是:蜘蛛抓取网站数据用于非法用途,都属于坏蜘蛛,比如黑蜘蛛(听名字就不是什么好蜘蛛)。

蜘蛛抓取频次怎么理解?

下面以百度蜘蛛为例。请看百度官方的解释:

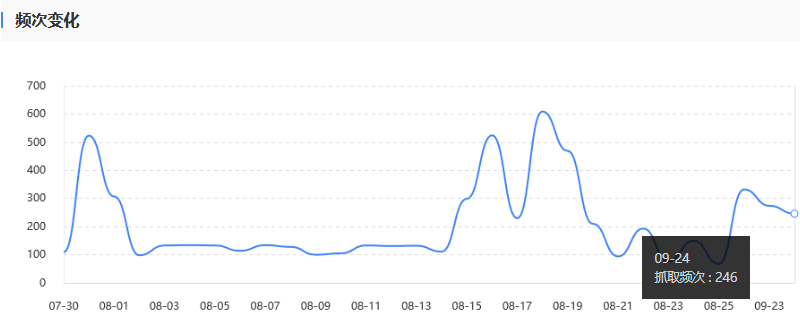

1. 抓取频次是搜索引擎在单位时间内(天级)对网站服务器抓取的总次数,如果搜索引擎对站点的抓取频次过高,很有可能造成服务器不稳定,Baiduspider会根据网站内容更新频率和服务器压力等因素自动调整抓取频次;

2. Baiduspider会根据网站服务器压力自动进行抓取频次调整;

3. 建议您慎重调节抓取频次上限值,如果抓取频次过小则会影响Baiduspider对网站的收录。

我们可以这样简单理解:在百度搜索资源平台看到的抓取频次,即为当天BaiduSpider对网站服务器抓取的总次数。

从上图可以看出:MAY的SEO博客在9月24日抓取了246次。

为什么百度蜘蛛抓取频次会有波动呢?

May曾特别观察了百度蜘蛛的抓取频次,意外发现:①网站文章更新越有规律;②更新文章质量越高,百度蜘蛛抓取的频次就越高,当然这个有待更进一步的验证。

那是不是百度蜘蛛抓取的频次越高,就越好呢?

百度官方也指出:如果搜索引擎对站点的抓取频次过高,很有可能造成服务器不稳定。毕竟凡事都有个度嘛。对于其他蜘蛛也同样适用,并不是说抓取频次越高对网站就越有利。

那有什么办法可以控制蜘蛛的抓取频次呢?

网站文章更新的频率及文章的质量,会影响到百度蜘蛛的抓取频率。那为了降低蜘蛛的抓取频次,我是不是应该减少文章更新及不重注文章质量呢?呵呵,大家不要钻空子哟。首先,May在前面就已经说明了文章更新频率及文章质量是否会影响到百度蜘蛛抓取频率,这个有待验证,只是May的个人看法。但从反向说,如果我们网站上不更新文章或文章大多都是采集的,百度蜘蛛会来吗?如果连百度蜘蛛都不来,网页怎么被抓取到,怎么会有排名?因此,只要我们有规律地更新文章并注重文章质量,百度蜘蛛并不会那么傻,抓取频次就一定会到达上限,百度官方也有说明Baiduspider会根据网站服务器压力自动进行抓取频次调整。所以大家不必太过于担心。万一达到一定的极限导致服务器压力过大,我们也是可以去调整抓取频次上限值。其他搜索引擎蜘蛛也是一样的哟。

有什么办法可以屏蔽蜘蛛的抓取呢?

有的时候一些莫名其妙的蜘蛛总是访问我的站点,我想屏蔽某蜘蛛的抓取,让它的抓取频次为0,该怎么办呢?

使用robots协议来屏蔽某些蜘蛛的抓取,在robots.txt中加入这样的语句:

User-agent: CCbot(想要限制的蜘蛛名称) Disallow: /

查看某网站的robots.txt文件,在地址栏输入https://may90.com/robots.txt(换成自己的域名)即可。

但记住:robots.txt是指令,大多数的蜘蛛都会遵守,但同样无法避免的是有些蜘蛛并不会完全遵守。

曾经May的SEO博客屏蔽了一些蜘蛛,推荐大家阅读:

没有价值的单个页面怎么禁止搜索引擎蜘蛛抓取?

没有价值的单个页面,也就是那些不重要的页面,完全没有必要让搜索引擎蜘蛛花费一些精力来抓取,那如何有效阻止呢?让它的抓取频次变为0?

有人使用robots.txt来禁止搜索引擎蜘蛛抓取这些不重要的页面,这种方法也是可取的。但不知道大家有没有发现,这些不重要的页面往往会有很多链接指向它,包括网站内部的链接,甚至有可能还存在一些外部链接。我们可以使用robots.txt来规定搜索引擎蜘蛛在网站上的爬行范围,但无法控制外部的链接,很有可能蜘蛛通过其他的渠道将我们网站上的一些没有价值的页面编入索引,因此最佳的方法是使用noindex漫游器元标记,在这种情况下,我们不应该在robots.txt中禁止该页面,因为必须允许搜索引擎蜘蛛抓取该页面才能看到noindex标签并遵守该标记。关于noindex标签,推荐您阅读《如何使用漫游器标记noindex?》。

蜘蛛抓取频次对SEO优化的影响,相信大家会有一个全新的认识。

关键词:蜘蛛抓取频次